De mitos a agentes: historia de la inteligencia artificial y el nacimiento de los AI Agents

Los AI Agents nos rodean por todas partes, pero en realidad esta tecnología es un pequeño enano que se alza sobre los hombros de muchos gigantes. Para que no haya una gran brecha entre el pasado y el presente, puedes leer esta breve historia del desarrollo de la inteligencia artificial.

La inteligencia artificial ha recorrido un camino increíble desde conceptos filosóficos hasta sistemas potentes capaces de realizar tareas complejas de forma independiente. Esta historia está llena de altibajos y avances revolucionarios. Hagamos un viaje fascinante a través de los momentos clave del desarrollo de la IA que han llevado a la aparición de los AI Agents modernos.

Antiguos sueños de máquinas pensantes

La idea de crear una mente artificial no es nueva: sus raíces se remontan a la antigüedad. En los mitos de la Antigua Grecia, se encontraban autómatas: muñecos que realizaban acciones según un algoritmo dado. Por ejemplo, Pandora, creada por Zeus, puede considerarse una de las primeras "criaturas artificiales" mitológicas. En la cultura judía, existían leyendas sobre golems: creaciones hechas de materia inanimada, animadas por fórmulas mágicas, que pueden considerarse un antiguo prototipo de la IA moderna.

Más tarde, en el siglo XVII, los filósofos comenzaron a reflexionar seriamente sobre la posibilidad de una representación matemática del pensamiento humano. El pensador alemán Leibniz creía que los pensamientos humanos podían expresarse matemáticamente mediante símbolos y esquemas especiales, una idea sorprendentemente consonante con los principios modernos de funcionamiento de la inteligencia artificial.

Estos primeros conceptos, aunque fantásticos para su época, sentaron las bases para futuras investigaciones científicas, demostrando que el sueño de crear una mente artificial ha acompañado a la humanidad durante milenios.

El nacimiento de la IA moderna: los primeros pasos (1940-1970)

La verdadera historia de la inteligencia artificial comenzó a mediados del siglo XX. Un punto de inflexión fue la histórica conferencia de Dartmouth en 1956, donde se sentaron las bases de esta ciencia y se utilizó por primera vez el término "inteligencia artificial".

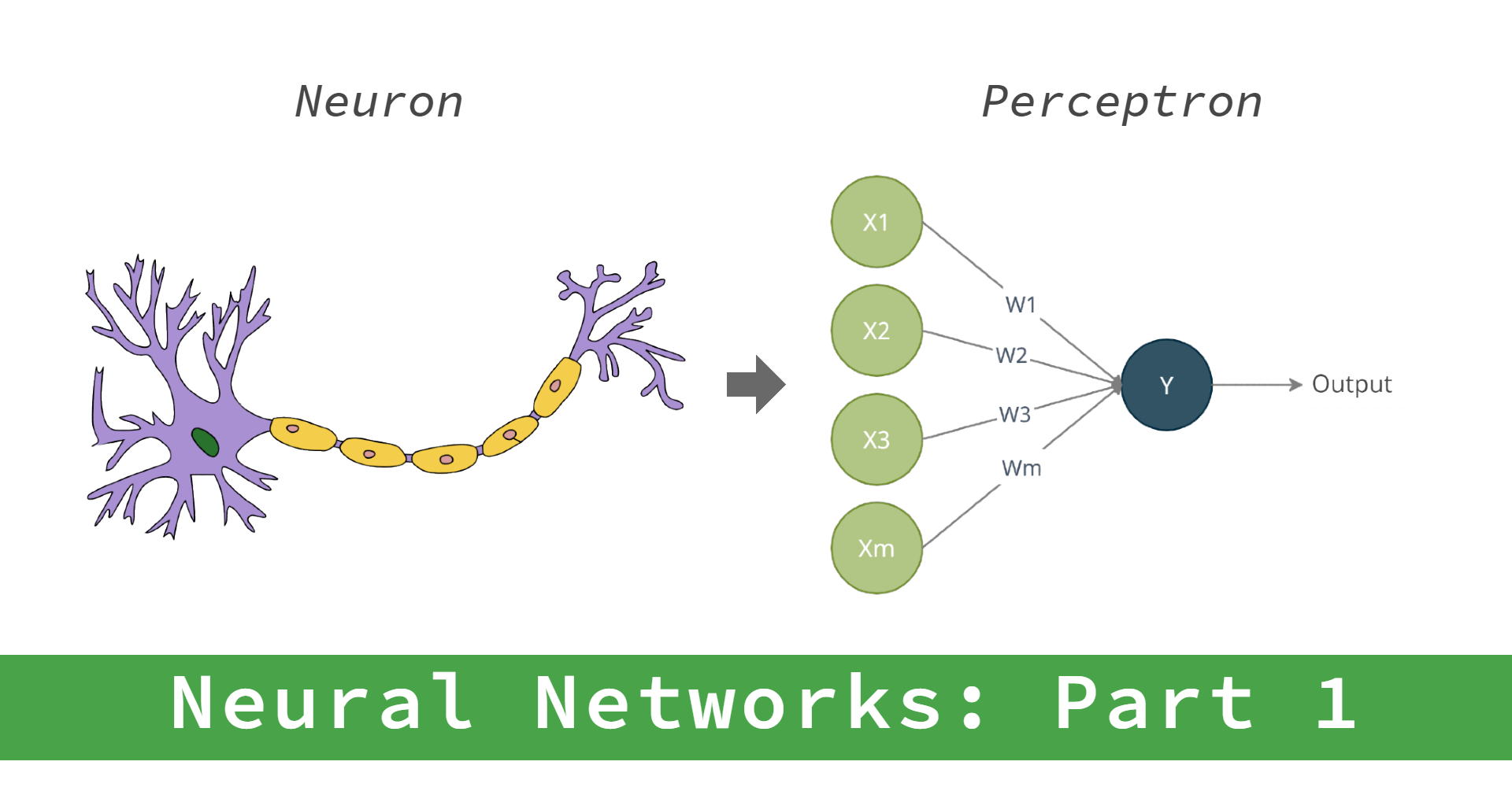

Sin embargo, incluso antes de este evento, se habían dado pasos importantes. En 1944, los investigadores de la Universidad de Chicago Warren McCulloch y Walter Pitts propusieron el primer modelo conceptual de una red neuronal, que imitaba el funcionamiento de las neuronas del cerebro. Esto se convirtió en la base teórica para futuros desarrollos.

Un verdadero avance se produjo en 1957, cuando el psicólogo de la Universidad de Cornell Frank Rosenblatt demostró la primera red neuronal entrenable, llamada perceptrón. Era un sistema de un solo nivel capaz de reconocer patrones simples y aprender de ejemplos. A pesar de su primitividad para los estándares actuales, el perceptrón fue un paso revolucionario, que demostró la posibilidad de crear sistemas de autoaprendizaje.

Altibajos: "inviernos de la IA" y el renacimiento de las redes neuronales (1970-2010)

La historia de la inteligencia artificial no ha sido lineal: los periodos de entusiasmo se han visto sustituidos por decepciones, denominadas "inviernos de la IA". Las limitaciones de la potencia computacional y las dificultades teóricas impidieron la realización de ideas prometedoras.

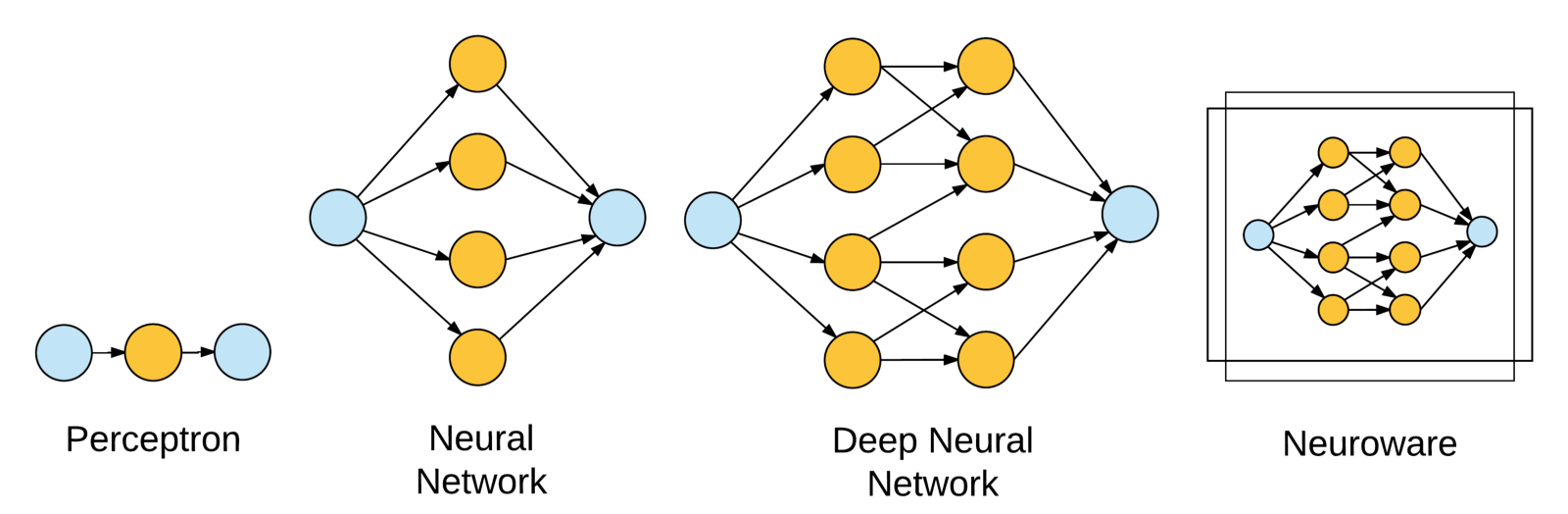

En la década de 1980, con la aparición de ordenadores más potentes, los investigadores pudieron desarrollar redes neuronales con dos y tres niveles de aprendizaje. Esto supuso un progreso significativo, pero hubo que esperar varias décadas para un verdadero avance.

Sorprendentemente, la revolución en el aprendizaje profundo se produjo gracias a... ¡la industria de los videojuegos! Los juegos modernos requerían cálculos complejos, lo que llevó al desarrollo de unidades de procesamiento gráfico (GPU), que combinan miles de núcleos de cálculo en un solo chip. Los investigadores descubrieron que la arquitectura de la GPU era ideal para entrenar redes neuronales. Este descubrimiento lanzó una nueva era en el desarrollo de la IA.

La revolución de los transformers: la atención lo cambia todo (2017)

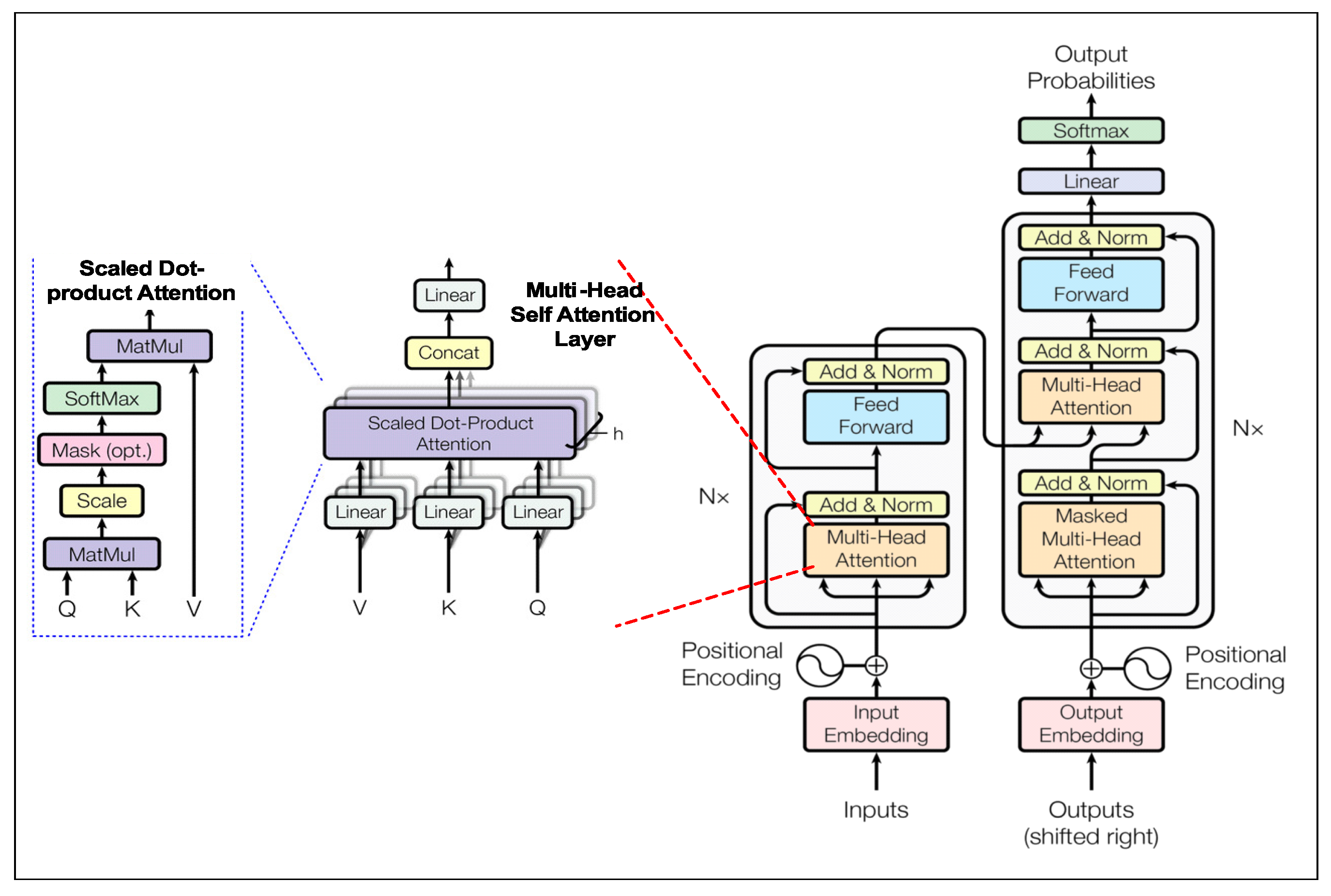

En 2017, se produjo un acontecimiento que cambió el panorama de la inteligencia artificial: se publicó el artículo "Attention is All You Need", que presentaba al mundo la arquitectura Transformer. Esta arquitectura, basada en el mecanismo de atención, permitió a los modelos comprender mejor el contexto en las secuencias de datos, lo que es especialmente importante para el procesamiento del lenguaje natural.

A diferencia de los enfoques anteriores, los transformers podían procesar eficazmente largas secuencias de palabras, teniendo en cuenta las conexiones entre elementos distantes. Esto abrió el camino a la creación de modelos capaces de comprender y generar textos indistinguibles de los escritos por humanos.

La era de los grandes modelos lingüísticos (2018-2022)

Basándose en la arquitectura de los transformers, en 2018 el laboratorio de investigación OpenAI presentó el primer modelo de la familia GPT (Generative Pre-trained Transformer). Aunque GPT-1 era más bien una prueba de concepto, demostró el potencial del preentrenamiento generativo para resolver tareas de procesamiento del lenguaje natural.

En 2019, apareció un GPT-2 más potente, que causó mucha controversia. Su capacidad para generar textos coherentes era tan impresionante que OpenAI inicialmente restringió el acceso a la versión completa del modelo, temiendo su posible uso para crear noticias falsas. Este caso planteó importantes cuestiones sobre la ética y la seguridad en el campo de la IA.

La verdadera revolución se produjo en 2020 con el lanzamiento de GPT-3, un modelo con 175.000 millones de parámetros. GPT-3 podía escribir poemas, crear código de software, redactar documentos legales y resolver muchas otras tareas sin necesidad de un entrenamiento especial para cada una de ellas. Este avance demostró que el aumento del tamaño del modelo conduce no sólo a cambios cuantitativos, sino también cualitativos en sus capacidades.

ChatGPT: La IA se vuelve accesible para todos (2022)

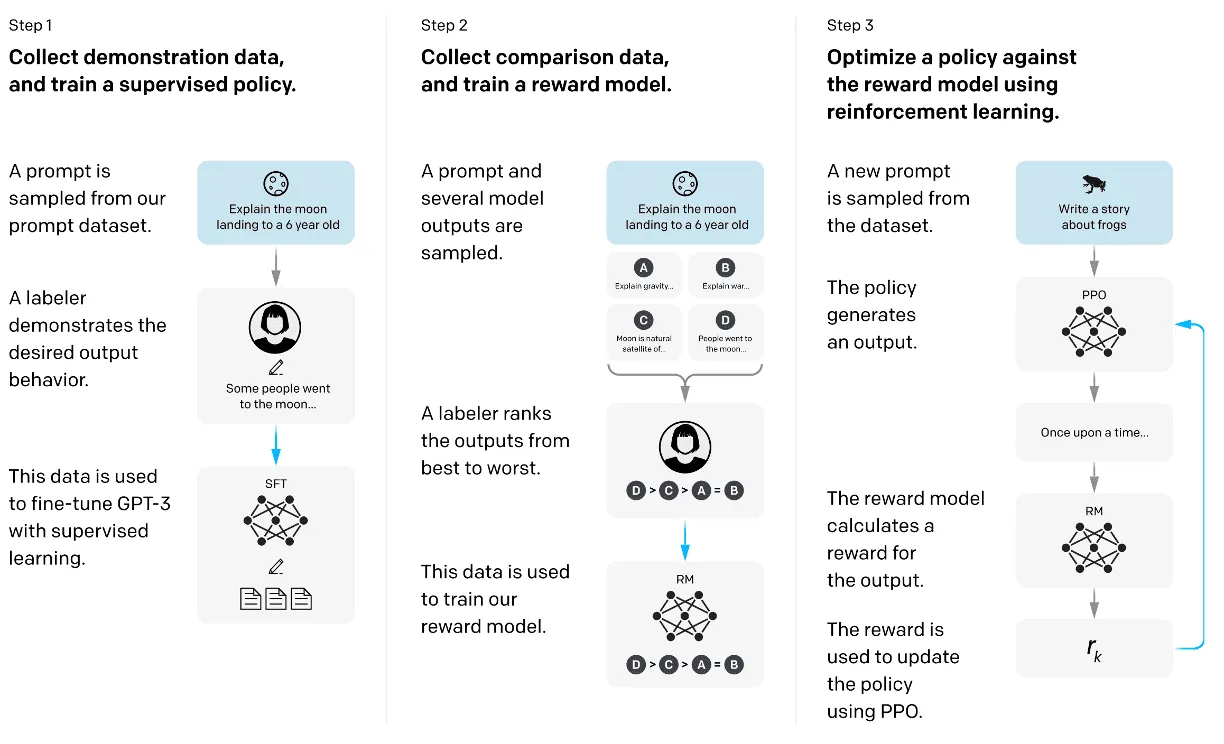

A finales de 2022, OpenAI presentó ChatGPT, un chatbot interactivo basado en el modelo GPT, entrenado mediante la técnica RLHF (Reinforcement Learning from Human Feedback - aprendizaje por refuerzo basado en la retroalimentación humana). Esto permitió crear un sistema capaz de mantener diálogos significativos y adaptarse a las peticiones de los usuarios.

ChatGPT se convirtió en un fenómeno cultural, ganando millones de usuarios en cuestión de días. Por primera vez en la historia, una potente IA se puso a disposición del público en general a través de una sencilla interfaz de chat. La gente lo utilizaba para escribir textos, resolver problemas, aprender idiomas, obtener consejos y muchos otros fines.

Es importante entender que ChatGPT no es un verdadero "agente" de inteligencia artificial, sino más bien un modelo lingüístico o asistente. No puede fijar objetivos de forma independiente, tomar decisiones independientes o actuar en el mundo real sin la dirección humana. ChatGPT funciona como un "copiloto" o asistente, que requiere dirección humana.

AI Agents: una nueva generación de inteligencia artificial (2023 en adelante)

Si bien los modelos lingüísticos como ChatGPT han revolucionado las interfaces de interacción persona-IA, el siguiente paso ha sido el desarrollo de verdaderos AI Agents: sistemas capaces de actuar de forma autónoma.

Los verdaderos AI Agents poseen una serie de características clave que los distinguen de los modelos lingüísticos ordinarios:

- Capacidad para fijar objetivos de forma independiente y planificar las formas de alcanzarlos

- Capacidad para tomar decisiones de forma autónoma sin necesidad de una intervención humana constante

- Memoria para aprender de las interacciones pasadas

- Integración con sistemas externos y fuentes de datos

Los AI Agents modernos pueden interactuar con diversas herramientas y API, planificar complejas acciones de varios pasos y adaptarse a las condiciones cambiantes. Son capaces de trabajar en segundo plano, realizando las tareas asignadas e informando de los resultados una vez finalizadas.

Entre los ejemplos de estos sistemas se encuentran AutoGPT, AgentGPT y otros proyectos que demuestran el potencial de combinar modelos lingüísticos con comportamiento autónomo y la capacidad de interactuar con el mundo exterior.

Conclusión: sobre los hombros de gigantes

Los AI Agents modernos se alzan sobre los hombros de gigantes: los logros de décadas de investigación y desarrollo en el campo de la inteligencia artificial. Desde los primeros modelos teóricos de redes neuronales hasta la revolucionaria arquitectura de los transformers, desde los perceptrones primitivos hasta los superpoderosos modelos GPT, cada paso ha sido importante para crear los sistemas que utilizamos hoy en día.

El mundo de los AI Agents apenas está empezando a revelar su potencial. Estos sistemas prometen cambiar la forma en que interactuamos con las tecnologías, automatizar las tareas rutinarias y ayudar a resolver problemas complejos en diversos campos, desde la ciencia y la medicina hasta la educación y la creatividad.

En los siguientes capítulos, examinaremos con más detalle cómo funcionan los AI Agents modernos, qué tareas pueden resolver y cómo se pueden utilizar eficazmente. Pero antes de profundizar en estos temas, era importante comprender el contexto histórico: el largo y sorprendente camino que ha llevado a la creación de estos innovadores sistemas.